人工智能专题报告:生成式人工智能产业全梳理

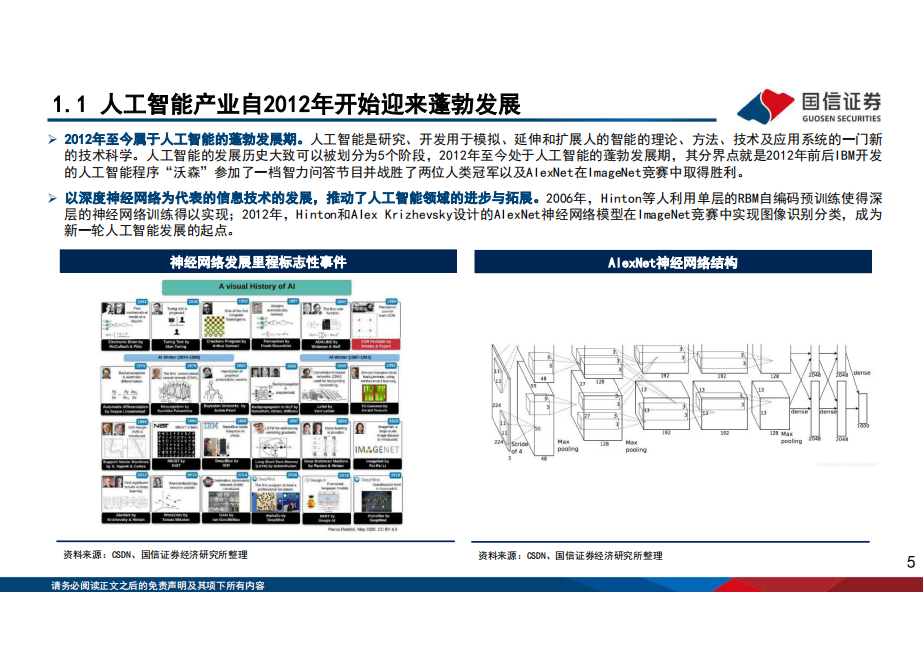

人工智能作为第四次科技革命,已经进入2.0时代。人工智能概念于1956年被提出,AI产业的第一轮爆发源自2012年,2012年AlexNet模型问世开启了CNN在图像识别的应用,2015年机器识别图像的准确率首次超过人(错误率低于4%),开启了计算机视觉技术在各行各业的应用。但是,人工智能1.0时代面临着模型碎片化,AI泛化能力不足等问题。2017年Google Brain团队提出Transformer架构,奠定了大模型领域的主流算法基础,从2018年开始大模型迅速流行,2018年谷歌团队的模型参数首次过亿,到2022年模型参数达到5400亿,模型参数呈现指数级长,“预训练+微调”的大模型有效解决了1.0时代AI泛化能力不足的问题。新一代AI技术有望开始全新一轮的技术创新周期。

自18年起大模型快速流行,有望重新定义生产力。2018年以来,预训练语言模型(PLM)及其“预训练-微调”方法已成为自然语言处理(NLP)任务的主流范式,该范式先利用大规模无标注数据通过自监督学习预训练语言大模型,得到基础模型,再利用下游任务的有标注数据进行有监督学习微调模型参数,实现下游任务的适配。在AI的1.0时代:存在模型碎片化明显、AI泛化能力不足等问题。“预训练+微调”大模型能显著降低AI工程化门槛,预训练大模型在海量数据的学习训练后具有良好的通用性和泛化性,细分场景的应用厂商能够基于大模型通过零样本、小样本学习即可获得显著的效果,使得人工智能有望构建成统一的智能底座,AI+赋能各行各业。本轮的生成式AI有望从简单的内容生成,逐步达到具有预测、决策、探索等更高的认知智能。

OpenAI当前已迭代五代模型,GPT-4开始布局多模态。OpenAI于2015年成立,微软于2019年开始与OpenAI建立战略合作伙伴关系,GPT共发布五代模型GPT-1、GPT-2、GPT-3、ChatGPT以及GPT4。GPT-1于2018年6月发布,首次将transformer与无监督的预训练技术相结合。2020年5月发布GPT-3,模型参数量为1750亿。2022年11月,OpenAI正式推出了对话交互式的ChatGPT。相比于GPT-3,ChatGPT引入了基于人类反馈的强化学习(RLHF)技术以及奖励机制。2023年3月,OpenAI正式推出GPT-4,成为目前较先进的多模态大模型。GPT-4主要在识别理解能力、创作写作能力、处理文本量以及自定义身份属性迭代方面取得进展。

百度于2023年3月正式推出大模型文心一言。文心一言主要由文心大模型提供支持,文心一言拥有有监督精调、RLHF、提示构建、知识增强、检索增强和对话增强六大核心技术。其中前三项与ChatGPT的技术十分类似,知识增强包括知识内化和知识外用;检索增强指基于百度搜索引擎,先对内容进行检索,再筛选出有用的部分整合输出结果;对话增强指记忆机制、上下文理解和对话规划等技术。

投资建议:建议关注基础层与应用层AI龙头。应用层建议关注:科大讯飞、金山办公、同花顺、广联达、凌志软件、彩讯股份、拓尔思、福昕软件、税友股份等。基础层建议关注海光信息、浪潮信息、景嘉微等。

部分内容展示:

点击右侧下载全文>>>人工智能专题报告:生成式人工智能产业全梳理